决策公平性是人类对人工智能最普遍关注的问题之一。以大模型为代表的人工智能公平性缺失可能会导致智能系统决策不公、信任度降低、系统失灵等后果,随之带来司法不公、资源分配不均、就业歧视、机会不均等一系列严重的社会和伦理道德问题。造成人工智能决策不公平的原因主要有两点:一是用于人工智能模型训练的数据大多来源于人为采集数据,本身存在天然的偏差;二是模型在训练过程中由于迭代交互的原因导致偏差的进一步放大。

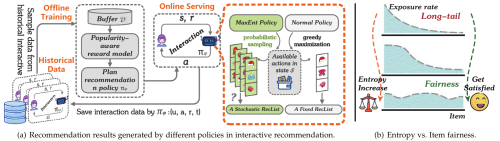

大数据挖掘及应用中心成员聚焦人工智能的典型应用场景——推荐系统,针对物品曝光偏差所导致的推荐决策不公平、用户不信任,进而造成推荐系统失效的严重后果,解析交互推荐过程中产生曝光偏差的本质原因,构建基于马尔科夫决策过程的动态交互新范式,提出推荐多样性和新颖性共融的强化学习去偏方法,助力高质量低曝光度物品的发现。进一步采用信息熵来对物品曝光公平程度进行精准刻画,建立基于动态软约束的公平推荐模型,实现了在长期交互过程中推荐效用和公平性的共同提升。

该研究揭示了曝光度偏差对交互式推荐的具体影响机制,强调了多样性和新颖性在消除推荐系统偏差中的重要性,同时也论证了在长期交互中推荐效用和公平性公赢的可能性,为人工智能、大模型公平性的研究提供了全新视角。相关研究成果发表在数据挖掘顶刊ACM Transactions on Information Systems(CCF-A)和服务计算领域顶级国际学术会议IEEE International Conference on Web Services(CCF-B)。

上述工作得到国家自然科学基金、金沙8888js官方“西部之光”计划,重庆市教委重点合作项目、教育教学改革研究计划项目支持。

相关论文链接:

https://www.computer.org/csdl/proceedings-article/icws/2023/048500a118/1QzhT2tdnGg

https://dl.acm.org/doi/10.1145/3618107

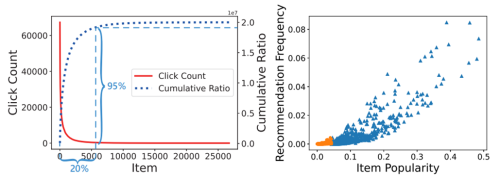

推荐系统中的流行度偏差

基于不同策略的离线强化学习方法的交互式推荐以及项目公平性问题